Fast Menschen: Wie wir mit AI-generierten Bildern arbeiten (und kämpfen)

Die neuesten KI-Bildgeneratoren versprechen beeindruckende Resultate mit nur einem Klick. Doch wie nah kommen diese Tools tatsächlich an Bilder, die direkt weiterverwendet werden können?

Es vergeht gefühlt kein Tag, an dem die Fähigkeiten generativer KI nicht um mindestens einen kleinen Schritt vorankommen. Als Tech-Begeisterte testen wir die neuesten verfügbaren KI-Tools immer gerne aus. Dieses Mal wollten wir in die Welt der KI-generierten Bilder eintauchen. Für einen kleinen Praxisversuch.

Schritt 1: Pick the Model

Nein, in der KI-Welt sind «Models» nicht Models, sondern Programme. Sie wurden mit einem Datensatz trainiert, den sie nutzen, um Bilder zu generieren. Das klingt vielleicht vage, und es hilft sicher nicht, dass viele dieser Modelle nach ihren Gründungsunternehmen benannt wurden. Midjourney etwa hat Modelle, die Midjourney v3, Midjourney v4, Midjourney v5, Midjourney v6 usw. heissen. Ein weniger verwirrendes Beispiel ist DALL-E, ein Modell der Firma OpenAI. Was ich damit eigentlich sagen will: Jedes Modell hat seinen eigenen Namen. Bitzli herzig, bitzli unheimlich.

Nach langer Recherche und viel Austesten bin ich beim Modell Mystic gelandet, das mit einem Freepik-Abo verfügbar ist (und ursprünglich von der Firma Magnific kreiert wurde). Zum Zeitpunkt dieses Blogposts hat Mystic die beste Prompt Adherence (d.h. die Übereinstimmung zwischen generiertem Bild und Textinput) und liefert die photorealistischsten Ergebnisse, die ich gesehen habe. Und schliesslich ging es mir bei dem Test um realistische Bilder.

Schritt 2: Prompten

Beim Prompten (ein «Prompt» ist auf Englisch eine Aufforderung) geht es darum, dem Modell in Worten zu beschreiben, was für ein Bild man generieren möchte.

Mit KI effektiv zu kommunizieren ist eine sehr wichtige Fähigkeit, die grossen Einfluss auf das Resultat hat. Der eigentliche Jobtitel für diese Rolle ist erst in den letzten zwei Jahren aufgekommen: Prompt Engineer.

Prompts folgen meist einer bestimmten Formel. Am effektivsten fand ich bisher etwas in dieser Richtung:

[Fotostil] Foto eines [Motivs], [wichtiges Merkmal], [weitere Details], [Pose oder Handlung], [Bildausschnitt], [Umgebung/Hintergrund], [Beleuchtung], [Kamerawinkel], [Kameraeigenschaften]

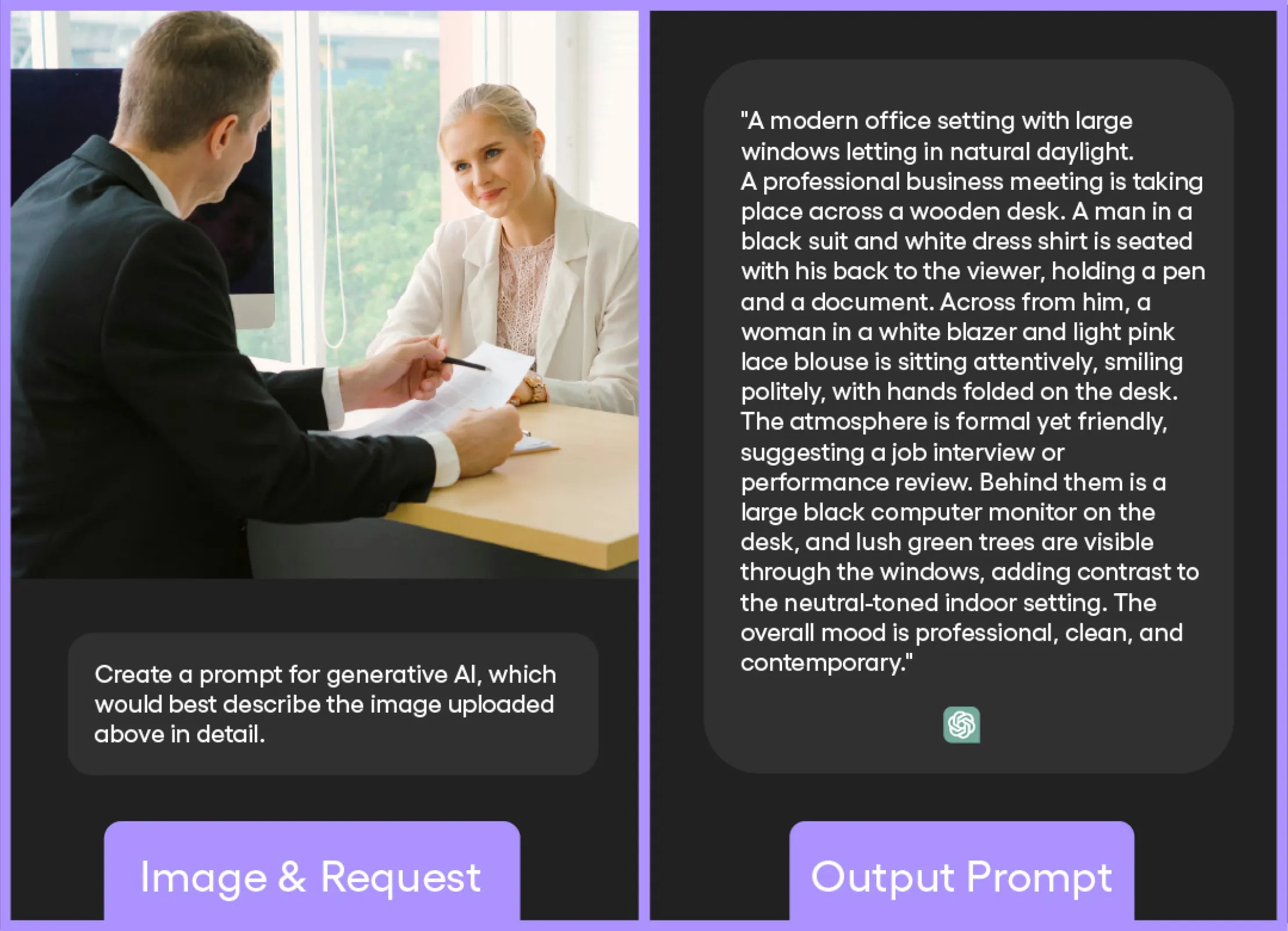

Da ich mit dieser Formel jedoch mal mehr und mal weniger Erfolg hatte, bin ich zu dem Schluss gekommen, dass ich mir beim Prompten wohl eine professionelle Meinung holen sollte. Und mit professionell meine ich in diesem Fall natürlich ChatGPT. Wer könnte schliesslich besser als eine KI verstehen, wie man mit KIs kommuniziert?

Mit ChatGPT kann man einen Prompt auch reverse-engineeren. Das heisst, man gibt ChatGPT ein Bild, das in die Richtung des gewünschten Bildes geht. ChatGPT verwandelt es dann in Nullen und Einsen. Aber das braucht uns nicht zu stören, denn dieser Prozess bleibt für uns unsichtbar. Innert Nanosekunden wird es in Text umgewandelt – der wiederum als Grundlage für einen Prompt dienen kann.

Selbst wenn man sich bei der Erstellung des Prompts von ChatGPT helfen lässt, wird das neue Bild nicht exakt dem Referenzbild entsprechen, aber es ist ein sehr guter Anfang.

Schritt 3: Bilder generieren

Endlich sind wir beim Teil, für den wirklich nur ein Klick auf einen Button nötig ist. Na ja, ausser dann, wenn mehrere Klicks verlangt werden. Manche KI-Modelle ermöglichen nämlich zusätzlich die Auswahl eines Bildstils, Formats, einer Bildgrösse und einer visuellen Richtung für das generierte Bild. Aber hey, immerhin geht es nur ums Klicken!

Unsere Klickfreude währt jedoch nicht lange. Bald werden wir mit der ernüchternden Realität der AI-Gruselgestalten konfrontiert, die uns an Stop-Motion-Horrorfilme aus den 80ern erinnern. Sobald Menschen gefragt sind, ist es schwierig, ein Ergebnis zu bekommen, das nicht vieeeel zu viele Zähne oder Finger beinhaltet. Oder das, was ich gerne Dämonenaugen nenne. Immerhin können sie nicht zurückstarren.

Aber im Ernst: Imperfektionen gibt es überall, insbesondere bei Objekten oder Naturbildern. Um ein korrekt aussehendes Bild zu erhalten, muss man oft Hunderte generieren. Und dann folgt erst die Auswertungsphase. Wenn du endlich das perfekte Bild erstellt hast, merkst du vielleicht, dass die Person auf dem Bild einen winzigen zusätzlichen Augapfel im lockigen Haar versteckt hat. Für diesen Schritt empfehle ich, eine Freundin oder einen Freund zurate zu ziehen. Denn wenn man sich zu lange auf Details fokussiert, sieht man vor lauter Bäumen den Wald nicht mehr. Zum Glück geht es im nächsten Abschnitt genau ums «Bigger Picture».

Schritt 4: Upscaling

Das Upscaling kann nicht übersprungen werden. Die von einer KI erstellten Fotos sind nämlich in der Regel sehr klein. Sie lassen sich vielleicht noch auf einer Website verwenden, beim Ausdrucken wären sie jedoch unbrauchbar.

Zum Glück gibt es sogenannte «Upscaler». Tools, die Bilder vergrössern, indem sie Details und Pixel hinzufügen. Wie genau sie funktionieren, ist etwas dunkle Magie, aber wie bei fast allen Dingen, die mit AI zu tun haben, vergrössern sie zunächst das Bild und versuchen dann, den Inhalt der hinzugefügten Pixel auf der Grundlage ihrer Trainingsdaten zu erraten. Upscaler sind im Grunde auch Modelle, allerdings werden sie auf ganz bestimmte Dinge trainiert, beispielsweise auf Bilder von Händen oder Augen, um dem Bild mehr Leben einzuhauchen.

Auf dem Markt gibt es zahlreiche Upscaler. Einige sind sehr individualisierbar und liefern tolle Ergebnisse, dafür laufen sie langsam. Andere sind sehr schnell und intuitiv, liefern aber vielleicht nicht immer beim ersten Versuch das gewünschte Ergebnis. Eines der am einfachsten zu bedienenden Programme war Magnific AI – und es lieferte auch anständige Resultate. Naja, es sei denn, es «halluzinierte» gerade alptraumhafte Dinge – der offizielle Begriff für KI-Fehler bei der Bildgenerierung.

Schritt 05: Eine Menge Photoshop und InvokeAI

Selbst die besten Upscaler erzeugen oft zusätzliche Fehler im Prozess. Die einzige Möglichkeit, ein perfektes Bild zu erhalten, ist – sehr zur Freude meiner kreativen Kollegen – die Verwendung von Bildbearbeitungsprogrammen wie Photoshop oder seinem entfernten KI-Cousin, InvokeAI.

Mit diesen Tools können wir unerwünschte Objekte entfernen, eigenartige Texturen ausbessern und zusätzliche Extremitäten entfernen. Auch die Kolorierung des Fotos lässt sich korrigieren – ein Prozess, den alle Fotografen durchlaufen müssen.

Sobald wir dem Bild den letzten Schliff verpasst haben, voilà! – haben wir ein fertiges Ergebnis. Und es war nur ein Klick-auf-einen-Button™ nötig.

Zeit für das Debriefing!

Obwohl es ein mühsamer Prozess war, bin ich vom Ergebnis wirklich überrascht. Trotzdem habe ich (zumindest mir selbst) definitiv bewiesen, dass gute Bilder weder schnell noch einfach zu generieren sind. Die Fotografie hat also noch eine lange und glückliche Zukunft vor sich.

Selbst ein einziges Bild zu generieren erforderte mehrere Tage Arbeit. Es gibt jedoch noch einen weiteren versteckten Preis zu zahlen, den ich bisher nicht erwähnt habe. Einerseits werden einige der KI-Modelle auf gestohlenen Inhalten trainiert, wodurch die Moralität und der Copyright-Status der generierten Bilder mindestens sehr fragwürdig werden. Andererseits gibt es auch das Problem der Leistung und der Ressourcen, die diese Tools benötigen.

Obwohl ChatGPT laut jüngsten Tests viel effizienter ist als angenommen, werden immer noch 0,3 Wattstunden pro Abfrage verbraucht. Das entspricht dem Betrieb einer LED-Glühbirne für 20 Minuten oder der Nutzung eines Smartphones für 15 Minuten.

Das mag auf den ersten Blick unbedeutend erscheinen, aber: Das ist die benötigte Energie für eine einzige Antwort von ChatGPT. Wenn wir mehrmals am Tag mit ChatGPT reden und eine Anfrage oft aus mehreren Prompts besteht, summiert sich das schnell. Ganz zu schweigen davon, dass die Erstellung von Bildern und Videos exponentiell mehr Strom verbraucht als eine einfache Textantwort – wobei unklar ist, um wie viel (die Schätzungen liegen zwischen dem Zehn- und Hundertfachen).

Das Urteil

Obwohl generative KI nützlich sein kann und sich in unserer Branche langsam durchsetzt, sind diese Tools bei weitem nicht die allumfassende Lösung, als die sie manchmal dargestellt werden. Selbst wenn KI irgendwann so weit fortgeschritten ist, dass sie wirklich aussagekräftige und aufmerksamkeitsstarke Inhalte erstellen kann, wird es meiner Meinung nach immer einen menschlichen «Piloten» brauchen. (Das klingt viel cooler als «Prompter», oder?)

Die Kunst liebt es ausserdem, rebellisch zu sein. Ich denke, dass künftige Künstler*innen Wege finden werden, um ihren Werken eine menschliche Komponente zu verleihen – wie auch immer das aussehen mag. Dieses persönliche Fazit lässt mich ruhiger schlafen – zumindest für die nächsten paar Jahre. Ich mache mir alles in allem keine allzu grossen Sorgen, dass ich so bald durch eine KI ersetzt werde. Allerdings hoffe ich doch sehr, dass es bis zur Entstehung der Cyborgs noch eine Weile dauern wird.